Durante esta semana tuve la oportunidad de asistir a la charla “A Self-Learning Cognitive Architecture for Scene Understanding Using Causality”, dictada por el Prof. José C. Príncipe, Distinguished Professor of Electrical and Computer Engineering de la University of Florida, IEEE Fellow y director del Computational NeuroEngineering Lab (CNEL). La presentación abordó uno de los desafíos más profundos de la inteligencia artificial: cómo construir sistemas capaces de comprender escenas visuales complejas de manera autónoma, sin depender de grandes volúmenes de datos etiquetados.

La propuesta se distancia de los enfoques dominantes basados exclusivamente en aprendizaje supervisado. En su lugar, plantea una arquitectura cognitiva inspirada en el sistema visual humano, integrando principios de neurociencia, modelos dinámicos, memoria, atención visual, causalidad y aprendizaje por refuerzo. El objetivo no es solo reconocer patrones, sino representar el mundo en términos de objetos y sus relaciones.

Uno de los mensajes centrales es que la visión autónoma sigue estando fuera del alcance de los paradigmas actuales. Aunque las redes profundas han demostrado un alto desempeño en tareas específicas, su dependencia de etiquetas y su limitada capacidad de generalización dificultan su aplicación en entornos abiertos y dinámicos. En este contexto, comprender el rol de la experiencia almacenada resulta clave.

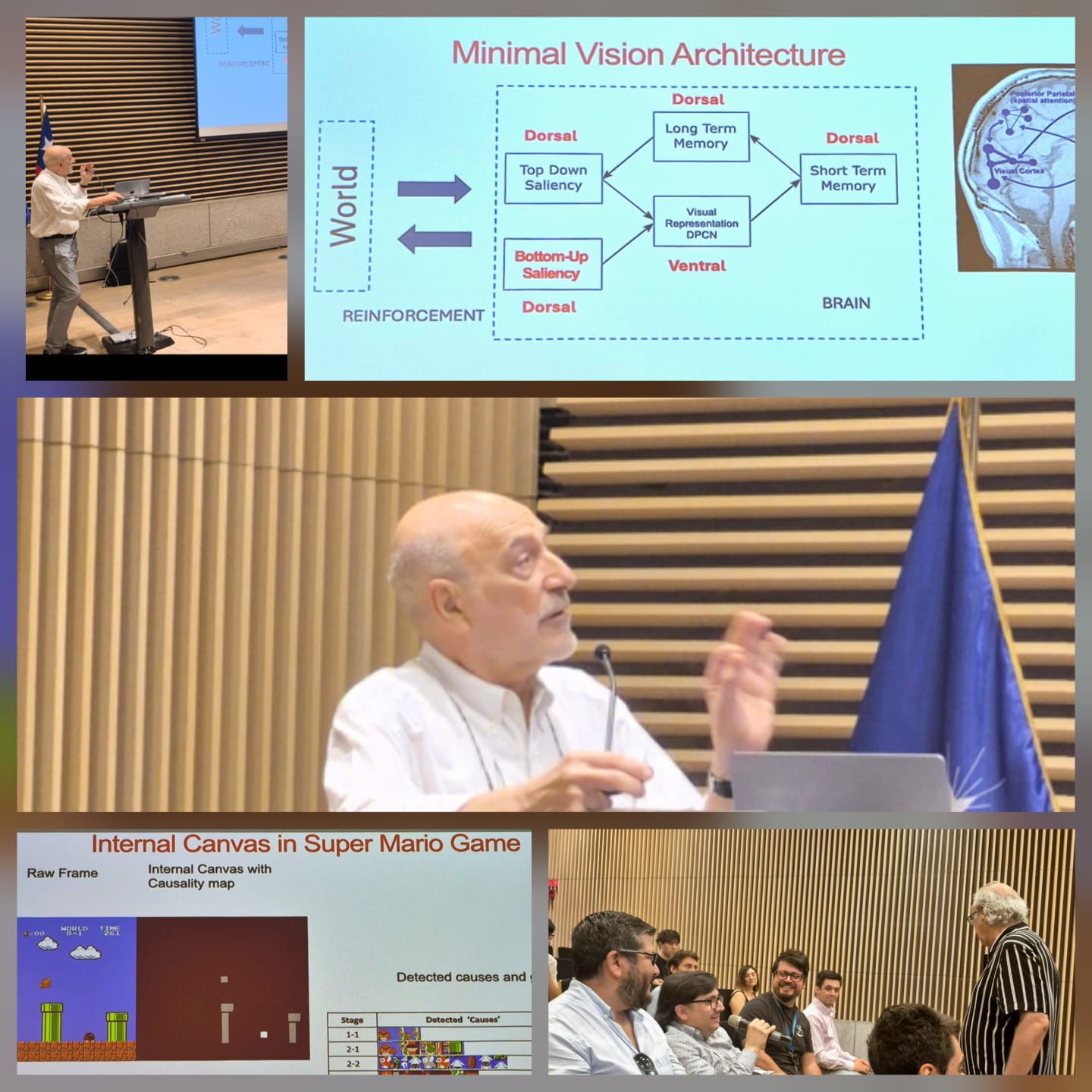

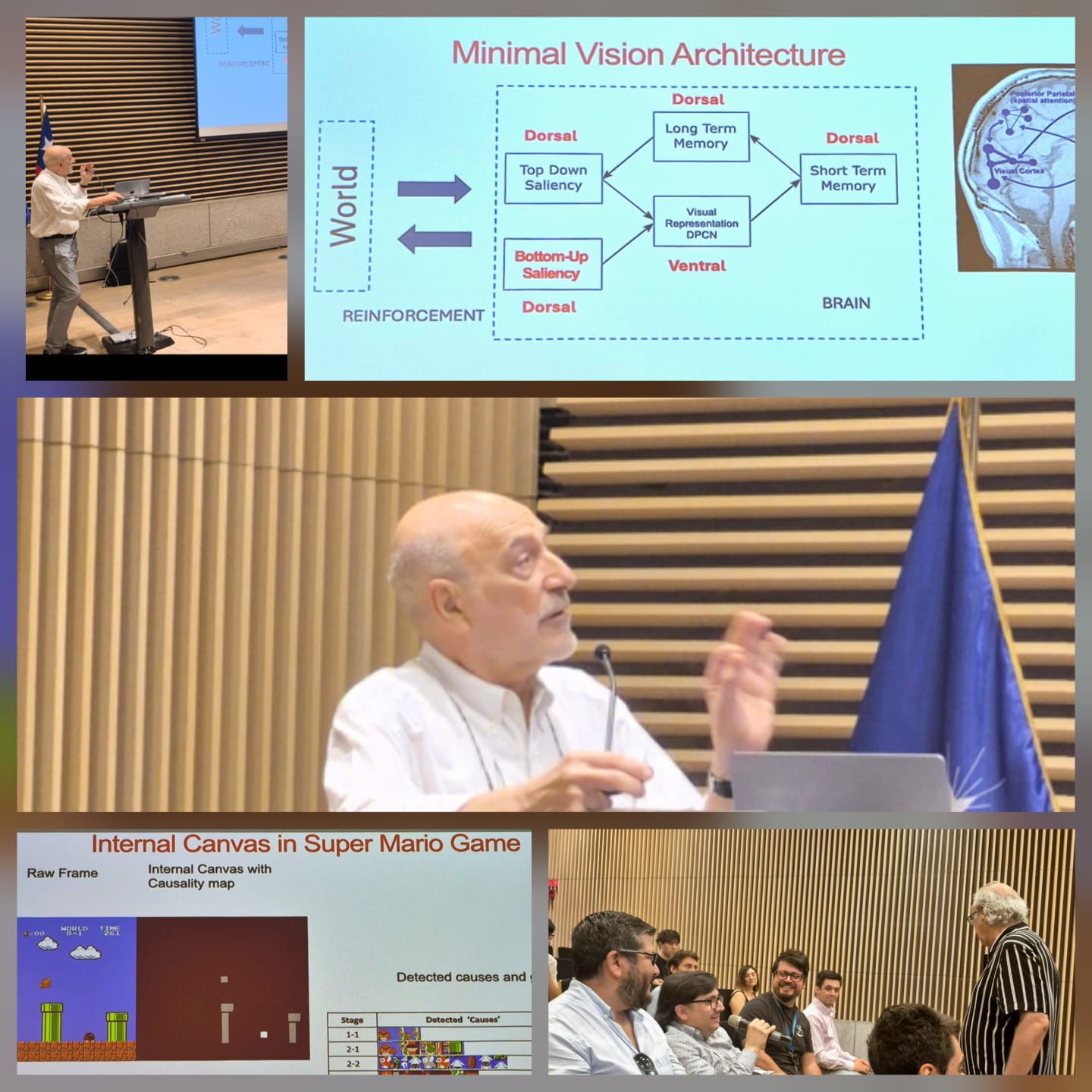

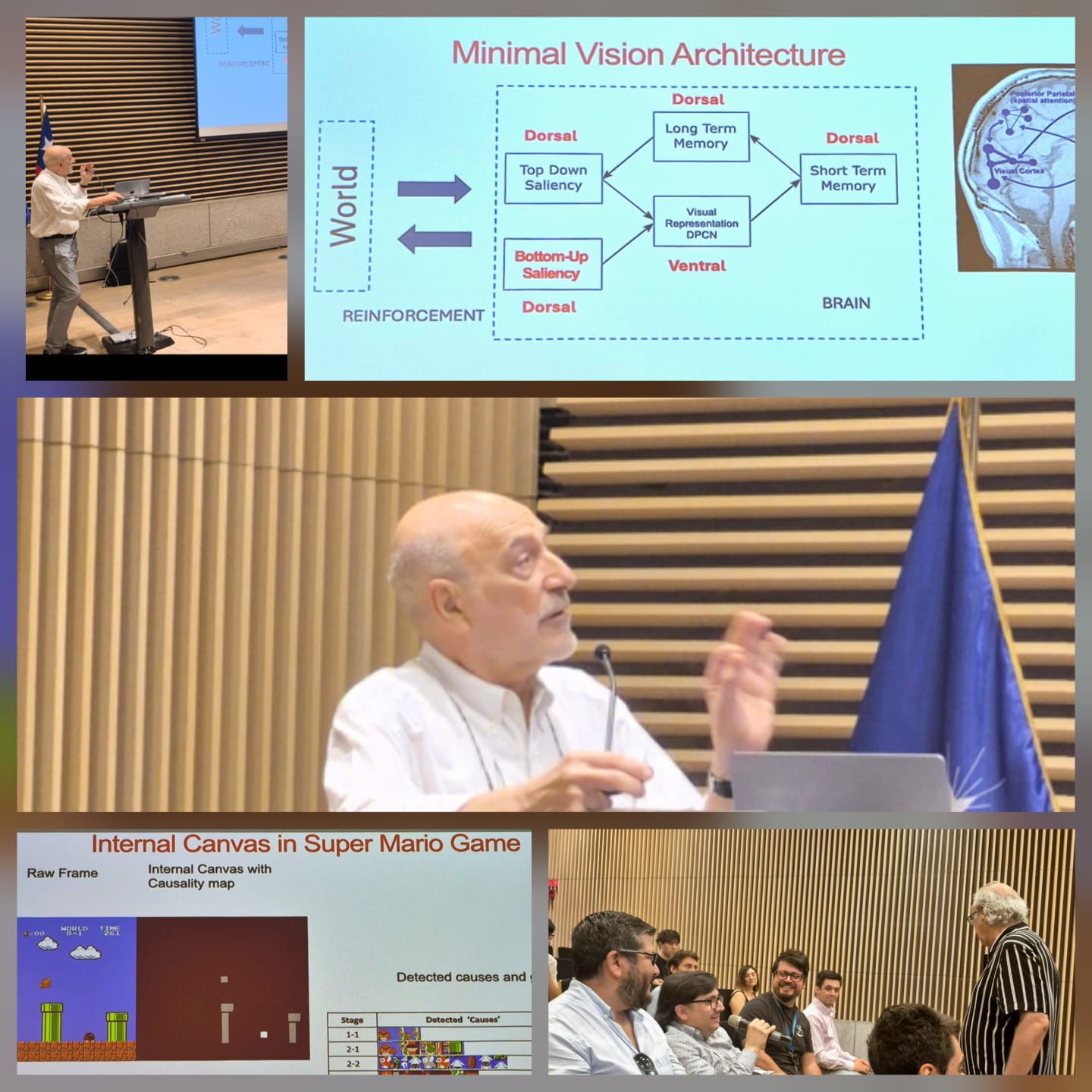

Figura 1: Collage de la charla del profesor José C. Príncipe.

En la vía ventral de la arquitectura, el procesamiento sensorial se modela mediante un sistema dinámico jerárquico con entradas causales desconocidas, basado en modelos de espacio de estados. Las observaciones representan la señal sensorial, los estados ocultos codifican la historia interna y las causas latentes capturan la estructura espacial del entorno. A través de priors bayesianos empíricos, las capas superiores intentan predecir las causas de las capas inferiores, siguiendo principios de codificación predictiva.

La arquitectura es multicapa y homogénea, con distintos niveles espaciales y temporales generados mediante pooling. El aprendizaje se realiza capa por capa, permitiendo la auto-organización progresiva de representaciones e invariancias similares a los campos receptivos observados en sistemas biológicos.

Un componente clave es la incorporación explícita de visión foveada, inspirada en los movimientos sacádicos del sistema visual humano. Cada sacada inicia un ciclo de percepción en el que se adquiere información, se procesa y se decide el siguiente foco de atención. Este mecanismo se aproxima mediante una cámara plenóptica (Lytro) y un enfoque de saliencia anidada que permite localizar y refinar regiones de interés.

Cuando los datos disponibles son limitados, la arquitectura incorpora atención top-down mediante aprendizaje por transferencia, utilizando redes profundas como VGG16 entrenadas en ImageNet para generar mapas de saliencia semántica. La combinación de atención bottom-up y top-down mejora la exploración visual del entorno.

Uno de los aportes conceptuales más relevantes es la introducción de una memoria de trabajo interna, denominada Canvas, que almacena objetos detectados y sus posiciones. Esta representación interna permite superar las limitaciones del aprendizaje por refuerzo directo desde píxeles, observado por ejemplo en experimentos tempranos con Super Mario Bros.

Al incorporar el Canvas, el agente puede focalizar el aprendizaje por refuerzo en los objetos relevantes, acelerando el entrenamiento y mejorando la transferencia entre tareas, al operar sobre representaciones estructuradas en lugar de estados visuales de alta dimensionalidad.

Para determinar qué objetos son relevantes, la arquitectura introduce explícitamente el aprendizaje basado en causalidad. En lugar de utilizar información mutua, se emplea el concepto de información dirigida, siguiendo los trabajos de Massey, con el fin de estimar la dirección del flujo causal entre las trayectorias de los objetos y las señales de recompensa.

El trabajo presenta además un estimador no paramétrico de información dirigida basado en la entropía de Rényi. Experimentos en distintos entornos muestran que la arquitectura identifica eficazmente los objetos relevantes, superando a métodos de deep reinforcement learning en velocidad de entrenamiento y desempeño en transferencia.

A modo de cierre, la charla del Prof. Príncipe refuerza la idea de que avanzar hacia sistemas de visión verdaderamente autónomos requiere integrar principios biológicos en el diseño de arquitecturas artificiales. La combinación de codificación predictiva, memoria, atención, causalidad y aprendizaje por refuerzo emerge como un enfoque prometedor para superar las limitaciones actuales de la visión computacional.

Entre los principales desafíos abiertos se encuentran la extracción de eventos a partir del flujo temporal continuo, el desarrollo de nuevas arquitecturas de memoria y la necesidad de métodos de aprendizaje por refuerzo más eficientes para operar en tiempo real. Estas preguntas motivaron una activa discusión final, orientada a la escalabilidad de la arquitectura hacia juegos de mayor complejidad y a su posible aplicación en dominios exigentes, como el análisis de imágenes médicas.

Para quienes deseen profundizar en los fundamentos teóricos y experimentales de esta arquitectura cognitiva, el artículo completo del

Prof. José C. Príncipe y colaboradores se encuentra disponible en la revista

Neural Networks y puede consultarse en el siguiente enlace:

https://www.sciencedirect.com/science/article/pii/S0893608022000703. Finalmente, agradezco al

Departamento de Ingeniería Eléctrica y al

profesor Pablo Estévez por la invitación y por facilitar este valioso espacio de encuentro académico y reflexión interdisciplinaria.